- Malte Busse

- April 18, 2024

- 9:00 am

Der EU AI Act – wer sagt, wann das Risiko zu groß wird?

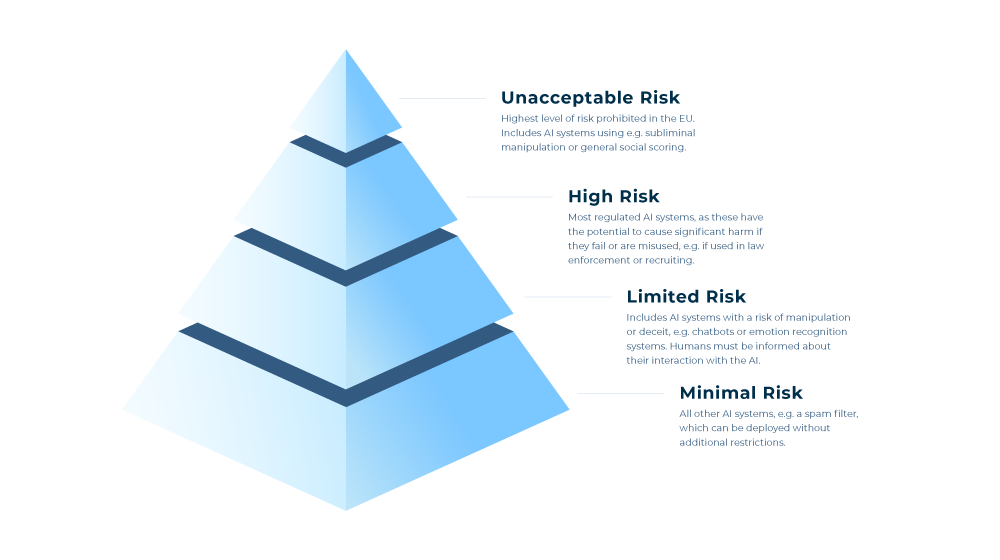

Mit dem EU AI Act ist die Europäische Union Vorreiter in Sachen Regulierung und Klassifikation von neu entstehenden KI-Anwendungen. Dieses Gesetz ist eine Reaktion auf wachsende Potenziale und Risiken, die KI-Technologien mit sich bringen. Ziel ist es, einen einheitlichen Rechtsrahmen für den Umgang mit KI-Systemen zu schaffen, KI-Innovation zu fördern und gleichzeitig elementare Grundrechte zu schützen. Die Herangehensweise ist scheinbar simpel: KI-Systeme werden in vier verschiedene Risiko-Kategorien sortiert. Je nach Kategorie gelten bestimmte Regularien und Voraussetzungen für die Entwicklung solcher Systeme. Wir wollen euch zeigen, wie genau der AI Act funktioniert und welche Schlüsselstellen es für Unternehmen zu beachten gibt.

Wo stehen wir im EU AI Act?

Mit Dezember 2023 sind die Europäische Kommission, der EU Rat sowie das EU Parlament zu einer politischen Übereinkunft gekommen. In dieser finalen Übereinkunft wurden Änderungen an den Kategorien der verbotenen und High Risk Systeme vorgenommen sowie „General Purpose AI Systeme“, kurz GPAI, final in den AI Act inkludiert. Der finale Gesetzestext steht somit fest, die genannten Risiko-Kategorien werden genauso kommen. Nun werden die Texte final adaptiert und in sämtliche EU-Amtssprachen übersetzt. Genau 20 Tage nach der offiziellen Publikation wird der EU AI Act in Kraft treten. Dann haben Unternehmen und Staaten 2 Jahre Zeit, Regularien und Produkte an den AI Act anzupassen, bevor Strafen und Vorgaben angewendet werden. Die EU bezeichnet dies als einen großen Meilenstein für die weltweit erste Gesetzesgrundlage zur Regulierung von Künstlicher Intelligenz. Doch auf KI nutzende Unternehmen kommt einiges zu.

Wichtig zu wissen: Nicht nur in der EU entwickelte Systeme fallen unter den AI Act. Auch Systeme die “nur” in der EU eingesetzt werden oder sogar solche, die Auswirkungen auf in der EU lebende Individuen haben, fallen unter die neuen Gesetze.

Die Risiko-Kategorien laut dem AI Act

Der EU Artificial Intelligence Act teilt KI-Systeme in vier verschiedene Risiko-Kategorien ein wie oben bereits erwähnt. Für die jeweiligen Kategorien wird es spezifische Voraussetzungen und Regularien geben. Wir bringen euch einen Überblick und zeigen Beispiele auf, was in die einzelnen Kategorien fällt.

Unacceptable risk oder auf deutsch „Nicht akzeptierbar“ kategorisierte KI-Systeme, die nicht mit den Werten und Grundgesetzen der EU vereinbar sind. Sie sind somit die höchste Risikostufe laut dem AI Act. Innerhalb dieser Kategorie werden Acht verschiedene Fälle angeführt. Diese Kategorien beinhalten vor allem Systeme, die die Grundrechte des Menschen gefährden könnten, manipulativ wirken, Bewertung von Personen vornehmen oder die Privatssphäre des Einzelnen berühren oder sogar verletzen.

KI-Systeme, die in diese Kategorien fallen, werden in der EU verboten.

High risk (hohes Risiko) Systeme sind die am stärksten regulierten Systeme in de EU. Hier wird es vor allem Überwachungs- und Sicherheitssysteme geben, die die Gesundheit und die Sicherheit sowie Grundrechte der Person und den Schutz der Umwelt überwachen sollen. Grund dafür ist das Risiko, dass besagte Systeme bei einem Ausfall oder einem Missbrauch starke negative Auswirkungen haben können.

Entscheidend für High Risk Systeme wird sein, die hochgesteckten Voraussetzungen zu erfüllen und so einen dauerhaften Betrieb zu gewährleisten. Wo wir zu Anfang am ehesten solche High Risk Systeme sehen werden, ist bei der Strafverfolgung und der Polizei, da diese besondere Ausnahmen darstellen.

Zusätzlich wird die Europäische Kommission eine öffentliche Liste bereitstellen, auf der sämtliche High Risk Systeme zu finden sind sowie dazugehörige Use Cases und die zugrunde liegenden Modelle. Einzig die von der Strafverfolgung genutzten Systeme werden nicht öffentlich gemacht, jedoch von einem unabhängigen Gremium überwacht und geprüft.

Die dritte Kategorie der limited Risk Anwendungen beinhaltet Systeme, die Gefahr laufen Täuschung und Manipulation zu produzieren. Die hierunter fallenden KI-Systeme müssen transparent gegenüber der User sein und diese im Falle der Interaktion mit einem KI-System informieren . Ein klassisches Beispiel hierfür sind Chatbots, aber auch generative AI wie ChatGPT und Co.

Die minimal Risk Kategorie und somit vierte und letzte Kategorie schließt alle anderen Systeme ein, die nicht unter die höheren Kategorien fallen. Diese Systeme unterliegen keinerlei Restriktionen oder Auflagen, jedoch müssen diese den Grundgedanken der EU entsprechen (Fairness, menschliche Kontrolle und keinerlei Art von Diskriminierung).

Anmerkung: die hier genannten und erklärten Kategorien können sich immer noch im Detail verändern.

Jetzt doch berücksichtigt: GPAI

Von vielen Expert:innen angeprangert, hat die EU in ihrem neusten Vorschlag nun doch die General Purpose AI-Systeme mit in die Gesetzgebung inkludiert. So werden nun auch die Systeme von Open AI und Aleph Alpha, die zuvor unter dem Radar flogen, den EU-Richtlinien unterworfen.

Die Risikokategorien beruhen auf den jeweiligen Use Cases – eine Definition für GPAI Use Cases ist eher schwierig, da wie der Name schon sagt, diese einen „general purpose“ haben und nicht eben diesen einen Use Case bedienen.

Daher bedient sich die EU einer weiteren Kategorisierung: die der non-systemic und systemic risk Kategorien. Diese sind abhängig von der nötigen Rechenleistung, um die einzelnen Modelle zu trainieren.

Die zugrunde liegenden Modelle müssen einen gewissen Grad an Transparenz aufweisen, die systemischen hingegen viel strengere Auflagen erfüllen. Entwickler von GPAI Systemen müssen zusätzlich relevante Informationen nachgelagerten Anbietern zur Verfügung stellen, die solche Grundmodelle in High Risk Systemen verwenden.

Anders verhält es sich mit öffentlichen Open Source Modellen. Diese können strengere Auflagen vermeiden, wenn das Modell und dessen Parameter für die öffentliche Nutzung, Bearbeitung und Vertrieb vorgesehen ist. Dieser Grundsatz gilt jedoch nur insofern, dass es keinerlei Risiko der Manipulation gibt und es keine Verbindung zu high oder unacceptable Risk Applikationen gibt.

Hilfreiche Tipps für Unternehmen

Für Unternehmen, unabhängig von Größe oder Standort, bedeutet der AI Act erstmal eines: Arbeit. Doch diese Arbeit ist entscheidend für den sicheren Einsatz von KI-Systemen und sichert vor sensiblen Strafen ab. Insbesondere Unternehmen sollten bereits jetzt anfangen, sich auf das Inkrafttreten des AI Acts vorzubereiten. Wie? Wir geben euch die wichtigsten Punkte, mit denen ihr euch auf das kommende Gesetz vorbereiten könnt!

Verstehen des EU AI-Acts

Beschäftigt euch mit dem AI Act und schult Mitarbeiter:innen jeglicher Stufe, um eine Wissensbasis im ganzen Unternehmen bzw. an den involvierten Stellen zu schaffen. Da es sich beim Thema KI um ein sehr schnellebiges Feld handelt, solltet ihr stets über Entwicklungen und Updates informiert bleiben und die neusten Themen immer im Blick behalten

Bestandsaufnahme und Klassifizierung der KI-Systeme

Dieser Schritt ist unausweichlich. Erstellt einen Überblick über bereits eingesetzte oder geplante KI-Systeme und klassifiziert diese im nächsten Schritt. Nur so kann bestimmt werden, in welche Risikoklasse diese fallen und welche Auflagen erfüllt werden müssen.

Risikobewertung und -management

Nach der Klassifizierung folgt die Risikobewertung dieser Systeme. Vor allem in Sachen Sicherheit, Datenschutz und Grundrechte ist Vorsicht geboten. Ist das geschehen, sollten Prozesse implementiert werden, um die ausgehenden Risiken zu minimieren oder gar ausschließen zu können.

Einhaltung der Transparenz- und Dokumentationsanforderungen

Detaillierte Dokumentationen über Datenquellen, Trainingsmethoden, Funktionsweise des Systems und Risikominderung helfen bei der Verwaltung. Viel Transparenz ist in diesem Fall das A und O, so verstehen User sowie betroffene Personen, wie die KI funktioniert.

Schulung und Sensibilisierung

Parallel dazu sollten sämtliche Mitarbeiter:innen auf diese Reise mitgenommen werden. Egal wie stark involviert, muss eine Grundsensibilisierung gegenüber diesem Thema geschaffen werden. Nur so schaffen wir Akzeptanz, was die Einhaltung des AI Acts unternehmensweit einfacher gestaltet.

Was bedeutet der AI Act nun?

Vorne Weg: der EU AI Act ist etwas Gutes. Mit dieser Gesetzgebung ist die EU ein Vorreiter in der Regulierung von KI-Systemen. Und das ist wichtig. Tech-Konzerne wie Meta und Google können bis jetzt ihre Systeme ohne große Hürden laufen lassen und User werden oft im Dunkeln gelassen, was genau mit ihren Daten passiert.

Mit dem Ansatz der Risiko-Kategorien versucht die EU, den Missbrauch von KI-Modellen zu verhindern und die Gesellschaft vor ungewollten Eingriffen zu schützen. Doch gleichzeitig bedeuten diese Anforderungen auch einen großen Dämpfer für die Entwicklung und Forschung. Die Kosten steigen enorm, um sicherzustellen, dass man nicht in der unacceptable oder High Risk Klasse landet. Entwicklungszeiten steigen bis ins Ungewisse. Die Gefahr: Unternehmen verlagern die KI-Entwicklung ins Ausland und auch Produkte werden im Ausland gelauncht bzw. überhaupt nur verkauft, da die Hürden in Europa zu groß werden.

Es bleibt spannend, in welchem Ausmaß der EU AI Act nun letztendlich kommen wird. Nur die Zeit wird zeigen, wie sich die Regulierungen auf die Entwicklung neuer Systeme auswirken wird. Wir jedenfalls schauen größtenteils positiv auf den AI Act, da für uns der Mensch im Mittelpunkt steht und KI vor allem eines sollte – Menschen helfen und unterstützen.

Wir entwickeln KI von Menschen – für Menschen.

FiveSquare – Aspiring the impossible